انتخاب ویژگی یا Feature Selection

برای مساله انتخاب ویژگی، راه حل ها و

الگوریتم های فراوانی ارائه شده است که بعضی از آن ها قدمت سی یا چهل ساله دارند.

مشکل بعضی از الگوریتم ها در زمانی که ارائه شده بودند، بار محاسباتی زیاد آن ها

بود، اگر چه امروزه با ظهور کامپیوترهای سریع و منابع ذخیره سازی بزرگ، این مشکل

به چشم نمی آید ولی از طرف دیگر، مجموعه های دادهای بسیار بزرگ برای مسائل جدید

باعث شده است که همچنان پیدا کردن یک الگوریتم سریع برای این کار مهم باشد. مساله

انتخاب ویژگی به وسیله نویسندگان مختلف، از دیدگاه های متفاوتی مورد بررسی قرار

گرفته است. هر نویسنده نیز با توجه به نوع کاربرد، تعریفی را از آن ارائه داده

است. در ادامه چند مورد از این تعاریف را بیان میکنیم:

1- تعریف ایده آل:

پیدا کردن یک زیرمجموعه با حداقل

اندازه ممکن، برای ویژگی ها است، که برای هدف موردنظر اطلاعات لازم و کافی را در

بر داشته باشد. بدیهی است که هدف تمام الگوریتم ها و روشهای انتخاب ویژگی، همین

زیر مجموعه است.

2- تعریف کلاسیک:

انتخاب یک زیرمجموعه M عنصری از میان N ویژگی، به طوریکه M < N باشد و مقدار یک تابع معیار (Criterion

Function) برای زیرمجموعه موردنظر، نسبت به سایر

زیرمجموعه های هماندازه دیگر بهینه باشد. این تعریفی است که

Fukunaga و

Narenda در سال 1111 ارائه داده اند.

3- افزایش دقت پیشگوئی : هدف انتخاب

ویژگی این است که یک زیرمجموعه از ویژگی ها برای افزایش دقت پیشگوئی، انتخاب شوند.

به عبارت دیگر کاهش اندازه ساختار بدون کاهش قابل ملاحظه در دقت پیشگوئی طبقه بندی

کنندهای که با استفاده از ویژگی های داده شده بدست می آید، صورت گیرد.

4- تخمین توزیع کلاس اصلی:

هدف از انتخاب ویژگی این است که یک

زیرمجموعه کوچک از ویژگی ها انتخاب شوند، توزیع ویژگی هایی که انتخاب میشوند،

بایستی تا حد امکان به توزیع کلاس اصلی با توجه به تمام مقادیر ویژگی های انتخاب

شده نزدیک باشد.

روش های مختلف انتخاب ویژگی، تلاش

میکنند تا از میان زیر مجموعه کاندید، بهترین زیرمجموعه را پیدا کنند. در تمام این

روش ها براساس کاربرد و نوع تعریف، زیر مجموعه ای به عنوان جواب انتخاب میشود، که

بتواند مقدار یک تابع ارزیابی را بهینه کند. با وجود این که هر روشی سعی می کند که

بتواند، بهترین ویژگی ها را انتخاب کند، اما با توجه به وسعت جواب های ممکن، و این

که این مجموعه های جواب به صورت توانی با

N افزایش پیدا می کنند، پیدا کردن جواب

بهینه مشکل و در Nهای متوسط و بزرگ بسیار پر هزینه است.

به طور کلی روش های مختلف انتخاب ویژگی را براساس نوع جستجو به دسته های مختلفی

تقسیم بندی می کنند. در بعضی روشها تمام فضای ممکن جستجو میگردد. در سایر روشها که

میتواند مکاشفه ای و یا جستجوی تصادفی باشد، در ازای از دست دادن مقداری از

کارایی، فضای جستجو کوچکتر میشود.

روش های مختلف انتخاب ویژگی

تکنیک های انتخاب ویژگی را می توان به دو شیوه دسته بندی کرد : در یک شیوه، روش های مختلف انتخاب ویژگی را براساس دو معیار تابع تولید کننده و تابع ارزیابی طبقه بندی میکنیم و براساس رویکرد دیگر تکنیک های انتخاب ویژگی را به سه دسته Filter ، Wrapper و embedded or hybrid تقسیم می کنیم.

روش فیلتر Filter برای انتخاب ویژگی:

ویژگی ها را براساس یک مرحله پیش

پردازش که الگوریتم یادگیری را نادیده می گیرد انتخاب میکند. روش فیلتر براساس

ویژگی های ذاتی داده بنا شده است نه

براساس دسته بند خاصی. ذات فیلترها برجستجوی ویژگی های وابسته و حذف غیر وابسته ها

است. الگوریتم های فیلتر بر پایه چهار معیار ارزیابی مختلف به نام های “مسافت

،اطلاعات ،وابستگی و سازگاری” ارزیابی می شوند .به راحتی برای دیتاست های با ابعاد

بالا به کار می روند. از نظر محاسباتی خیلی ساده و سریع هستند و مستقل از الگوریتم

دسته بندی هستند . شیوه کار آنها به این طریق است که ابتدا ویژگی ها را به وسیله

یک سری معیارها امتیازدهی می کند. سپس d تا از بهترین ویژگی ها را انتخاب می

کند. سپس این مجموعه به عنوان ورودی به الگوریتم دسته بندی، داده می شود. به بیان

دیگر به طور مستقل به تک تک ویژگی ها امتیازی داده می شود و سپس براساس آن

امتیازات مرتب می شوند. این امتیازات می توانند نشان دهنده رابطه بین ویژگی و

عنوان کلاس باشند. بدین منظور می توان از تست

t یا تست فیشر استفاده کرد. مشکل رویکرد

فیلتر آن است که رابطه درونی بین ویژگی ها درنظر گرفته نشده و ممکن است مجموعه

انتخابی دارای تعداد زیادی ویژگی وابسته به هم باشد، درنتیجه هدف ما که کاهش ویژگی

تا حد ممکن و حذف ویژگی های غیرضروری است را محقق نمی سازد.

انتخاب ویژگی به روش Wrapper:

این رویکرد مجموعه ویژگی را براساس دسته بندی کننده، انتخاب می کند و این مجموعه را با استفاده از دقت پیش بینی یا میزان خوب بودن خوشه ها امتیازدهی می کند یعنی کلاس بندی را یک جعبه سیاه محسوب می کند و زیر مجموعه ویژگی ها را براساس توان پیش بینی آن ها رتبه بندی می کند. این متد از بعضی استراتژی های جستجو مثل SFS و SBS استفاده می کند. این روش ها به روش های ترتیبی منسوب هستند. در این رویکرد، تمامی زیرمجموعه های ممکن از ویژگی ها درنظر گرفته می شود و با ارزیابی همه حالت ها بهترین آن ها که کمترین خطای عمومی را به همراه دارد انتخاب می شود. این متدها در انواع مسائل قادر به یافتن بهترین پاسخ می باشند. اگرچه ممکن است روش های wrapper نسبت به روش های فیلتر نتایج بهتری را تولید کنند ولی اجرای این روش ها پرهزینه است و در بعضی مواقع که تعداد ویژگی ها زیاد باشد منجر به شکست می شوند. مشکل اصلی روش های بسته بندی پیچیدگی بسیار بالاست که منجر به کنترل ناپذیرشدن مسیر حل مسئله می شود.

روش Embedded برای انتخاب ویژگی:

این مدل از مزایای هر دو مدل قبلی به وسیله استفاده از معیارهای ارزیابی مختلفشان در مراحل متفاوت جستجو سود می برد. در متد embedded جستجو برای یک مجموعه ویژگی بهینه ، درون ساختار دسته بندی کننده قرار دارد. در این رویکرد کنترل انتخاب تعداد مناسب ویژگی مشکل است و معمولا با افزونگی ویژگی ها مواجه می شویم. در اینجا نیز ارتباط بین ویژگی ها نادیده گرفته شده است که باعث مشکلاتی در انتخاب نهایی ویژگی ها می شود.

الگوریتم انتخاب ویژگی قطره های آب

الگوریتم چکه آب های هوشمند یا چکاه (Intelligent Water Drops)، یک الگوریتم انتخاب ویژگی بر پایه هوش گروهی است. الگوریتم چکه، الگوریتمی است که به گونه گروهی کار میکند و الهام گرفته از طبیعت است. این الگوریتم در اصل برای انتخاب ویژگی ترکیبیاتی (Combinatorial optimization) به کار برده میشود ولی میتوان آن را برای انتخاب ویژگی پیوسته (Continuous optimization) نیز آماده ساخت. این الگوریتم نخستین بار در سال ۲۰۰۷ میلادی، برابر ۱۳۸۶ خورشیدی برای یافتن گشایش و راه حل برای مسأله فروشنده دورهگرد پیشنهاد شد. از آن پس، شماری از پژوهشگران در پی بهبود و به کار بستن این الگوریتم برای مشکلها و مسئلههای گوناگون بودهاند.

قطرههای آب موجود در رودخانهها می توانند به طور هوشمندانه کوتاهترین مسیر را در رسیدن به دریا پیدا کنند. الگوریتم قطره های هوشمند آب در سال ۲۰۰۷ بر اساس این رفتار ارائه شد. در این الگوریتم قطره های آب دارای دو ویژگی مهم سرعت و میزان خاکی هستند که از زمین دریافت کردهاند و با خود جابهجا می کنند. هرچه میزان خاک آنها کمتر باشد سرعت آنها میتواند بیشتر شود. میزان خاک در واقع اطلاعاتی است که بین زمین و قطرههای آب مبادله میشود. چون هرچه تعداد قطره های بیشتری از یک زمین عبور کرده باشند میزان خاک آن کمتر است یک قطره مسیری را ترجیح می دهد که خاک کمتری داشته باشد. اگر گامهای حرکت قطرهها به صورت گسسته باشد میتوان فرض کرد قطره روی نودهای یک گراف در حال حرکت است. عملکرد الگوریتم که در آن قطرههای آب نماینده پاسخهای مساله هستند و به صورت رندم بر هریک از نودهای گراف مقداردهی میشوند به این صورت است که در تعدادی تکرار برای هر قطره مراحل زیر انجام می شود :

۱- به ازای هر نود بعدی آن نود با احتمال P طوری انتخاب می شود که قبلا مشاهده نشده باشد و ضمنا شروط مساله را نیز نقض نکند. P متناسب با معکوس میزان خاک بین دو نود مربوطه است.

۲- سرعت قطره به روزرسانی می شود به طوریکه هرچه خاک بیشتری بین دو نود وجود داشته باشد مقدار کمتری به سرعت آن افزوده میشود.

۳- میزان خاکی که قطره از مسیر جمعآوری میکند متناسب با مقدار هیوریستیک مساله و همچنین معکوس سرعت ذره محاسبه میگردد. (∆soil(i,j))

۴- میزان خاک موجود بین دو نود و خاکی که توسط قطره حمل میشود توسط ∆soil(i,j) به روزرسانی میشود.

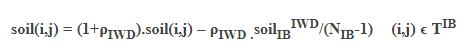

در پایان هر تکرار بهترین مسیر پیموده شده توسط همه قطره ها از نظر کارایی پیدا شده و خاک موجود در مسیرهای آن با توجه به میزان مطلوبیت این مسیر به روز رسانی می شود. در این به روزرسانی ضمن کم شدن میزان خاک مسیر با توجه به خاک حمل شده توسط قطره و تعداد نودها مقداری به آن اضاف هم می شود تا شانس جست و جوی مسیرهای دیگر در تکرارهای بعدی از بین نرود.رابطه به روزرسانی بهترین مسیر در تکرار جاری به صورت زیر است:

که در آن ρIWD پارامتر به روزرسانی سراسری، NIB تعداد نودهای بهترین مسیر در تکرار جاری و soilIBIWD قطره ای است که بهترین مسیر را پیموده است. soil(i,j) میزان خاک بین دو نود در بهترین مسیر جاری است .

ناب لرنینگ |

بزرگترین بانک اطلاعاتی پروژه های دانشجویی

ناب لرنینگ |

بزرگترین بانک اطلاعاتی پروژه های دانشجویی